人工知能の最初のバージョンは、時々迷惑なエラーを起こす傾向があります... 2024年2月にGoogleがしなければならなかったときに覚えておいてくださいつるすジェミニの画像の生成。彼のAIは、アメリカの建国の父親の中で黒人ナチの兵士と女性を代表しており、会社にこの機能を一時的に無効にすることを強制しました。

Apple Intelligenceはルールの例外ではありません。イギリスまたは米国で既にApple IAツールを使用している場合、通知の要約に間違いに気付いたかもしれません。 BBCとニューヨークタイムズは犠牲者でしたAIによって生成されたいくつかの誤った情報。 Apple Firmは現在、その画像ジェネレーターを備えた新しい課題に直面しています。

深いステレオタイプ

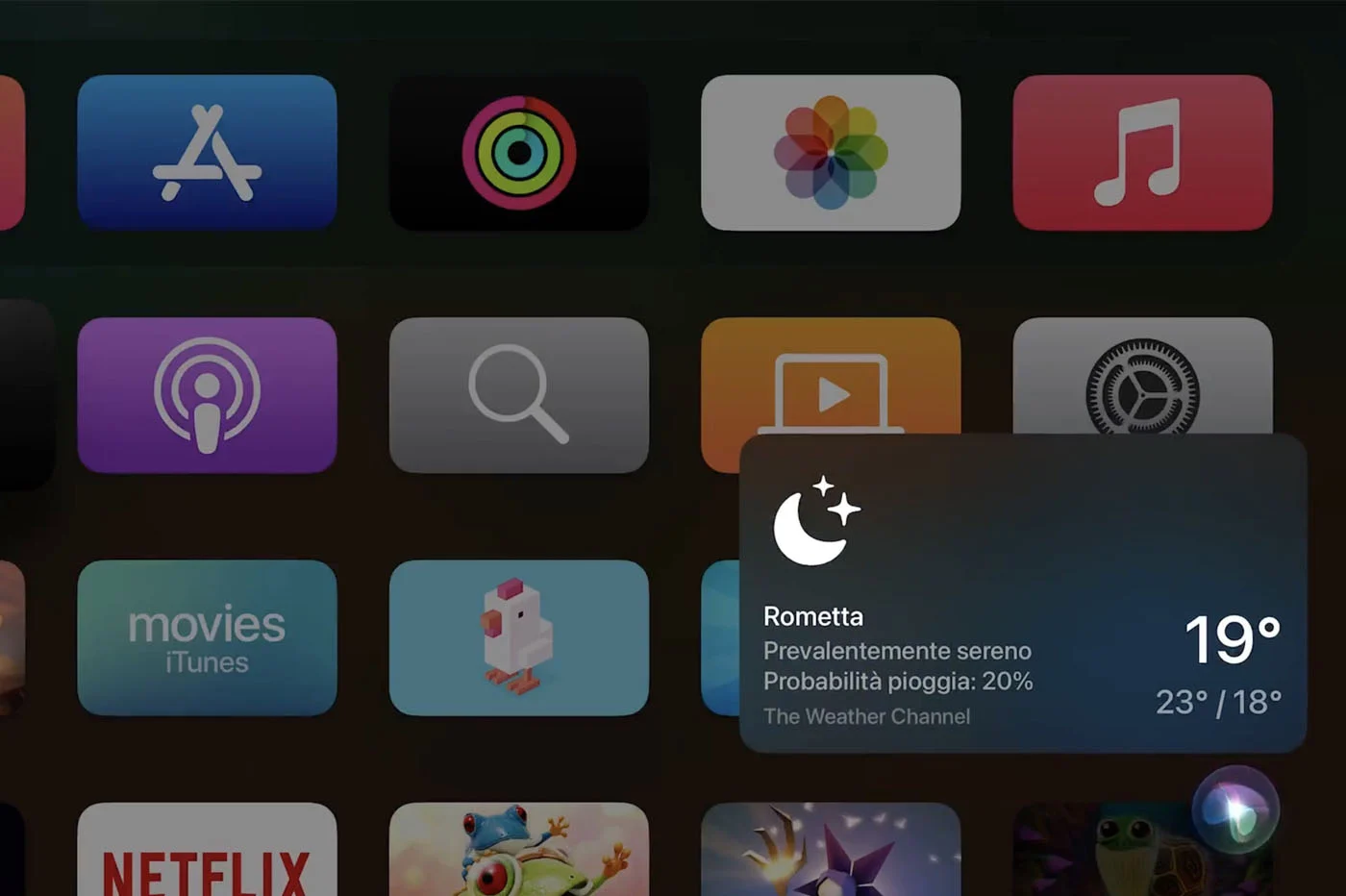

Apple Intelligenceの画像生成ツールである遊び場の画像は、多様性を管理するのに苦労しています。 Jochem Gietema Language Modelsの専門家は、写真を登録することでシステムをテストし、驚くべき結果を得ました。aiは被験者の肌の色をためらいます、代表者は時には白く、時には黒で、それ自体が非常に深刻なことはありません。

最も邪魔なのは、イメージの遊び場が十分に固定されたソーシャルショットを再現することです。 JochemがAppleジェネレーターに「リッチ」または「銀行家」で彼の画像を生成するように頼んだとき、このツールは、主に衣装で白い顔を生成します。逆に、「貧しい」または「農家」という言葉は、主にリラックスした衣装で暗い顔を生み出します。

いくつかのバイアスを見つけました@りんごの最新のテキストからイメージへの生成アプリであるImage Playground。 1つの特定の写真では、プロンプト(同じ入力画像)に応じて非常に異なる画像を作成します。いくつかの例:pic.twitter.com/no1osxvo8r

-jochemgietema(@gietema)2025年2月17日

私たちのバイアスを反映するAI

これらの結果は、AIの学習に関する疑問を提起します。画像の遊び場を訓練するために使用されるデータが来るようです社会的ステレオタイプが吹き込まれたベース。 Appleはおそらく、この種の差別的な協会を避けるためにそのアプローチを確認する必要があります。

ただし、これらのテストの起源の専門家は、これらのバイアスが体系的に表示されないことを指定しています。他の写真を出発点として使用する、遊び場の画像は、よりバランスの取れた結果を生み出します。したがって、Apple企業は、学習モデルの更新でこれらのドリフトを修正する必要があります。

i -nfo.fr -iphon.fr公式アプリ

平等:Ag Tescience